Nota

Haz clic en aquí para descargar el código de ejemplo completo o para ejecutar este ejemplo en tu navegador a través de Binder

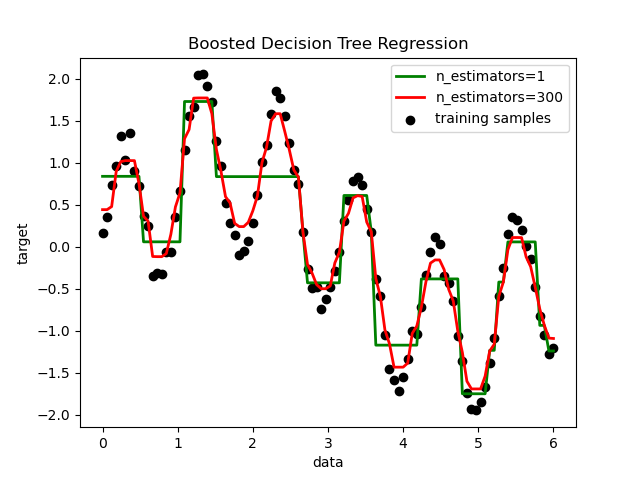

Regresión en árbol de decisión con AdaBoost¶

Se potencia un árbol de decisión utilizando el algoritmo AdaBoost.R2 1 en un conjunto de datos sinusoidales 1D con una pequeña cantidad de ruido gaussiano. Se comparan 299 boosts (300 árboles de decisión) con un único árbol de decisión regresor. A medida que se incrementa el número de boosts, el regresor puede ajustarse a más detalles.

- 1

Drucker, «Improving Regressors using Boosting Techniques», 1997.

print(__doc__)

# Author: Noel Dawe <noel.dawe@gmail.com>

#

# License: BSD 3 clause

# importing necessary libraries

import numpy as np

import matplotlib.pyplot as plt

from sklearn.tree import DecisionTreeRegressor

from sklearn.ensemble import AdaBoostRegressor

# Create the dataset

rng = np.random.RandomState(1)

X = np.linspace(0, 6, 100)[:, np.newaxis]

y = np.sin(X).ravel() + np.sin(6 * X).ravel() + rng.normal(0, 0.1, X.shape[0])

# Fit regression model

regr_1 = DecisionTreeRegressor(max_depth=4)

regr_2 = AdaBoostRegressor(DecisionTreeRegressor(max_depth=4),

n_estimators=300, random_state=rng)

regr_1.fit(X, y)

regr_2.fit(X, y)

# Predict

y_1 = regr_1.predict(X)

y_2 = regr_2.predict(X)

# Plot the results

plt.figure()

plt.scatter(X, y, c="k", label="training samples")

plt.plot(X, y_1, c="g", label="n_estimators=1", linewidth=2)

plt.plot(X, y_2, c="r", label="n_estimators=300", linewidth=2)

plt.xlabel("data")

plt.ylabel("target")

plt.title("Boosted Decision Tree Regression")

plt.legend()

plt.show()

Tiempo total de ejecución del script: (0 minutos 0.906 segundos)